9月11日,由生数科技和清华大学联合研发的自研原创视频大模型Vidu迎来重大更新“主体参照”(Subject Consistency)功能,该功能能够实现对任意主体的一致性生成,让视频生成更加稳定、可控。目前该功能面向用户免费开放。

主体参照功能上线 解决角色一致性问题

目前,无论是文生图功能,还是文生视频功能,一个广受诟病的问题就是图片或视频中出现形象的主体一致性问题。同样的提示词,同样的大模型,生成两次,所生成的内容并不一样,在艺术作品中,这就会导致主角的形象不能保持一致,也成为了AI生成作品与人类最大的区别之一。

为了解决这一问题,业界曾尝试采用“先AI生图、再图生视频”的方法,通过AI绘图工具如 Midjourney 生成分镜头画面,先在图片层面保持主体一致,然后再将这些画面转化为视频片段并进行剪辑合成。

但问题在于,AI 绘图的一致性并不完美,往往需要通过反复修改和局部重绘来解决。更重要的是,实际的视频制作过程中涉及众多场景和镜头,这种方法在处理多组分镜头的场景时,生图的工作量巨大,能占到全流程的一半以上,且最终的视频内容也会因为过分依赖分镜头画面而缺乏创造性和灵活性。

而在9月11日生数科技举办的媒体开放日活动上,生数科技展示了“主体参照”功能,该功能允许用户上传任意主体的一张图片,Vidu 就能够锁定该主体的形象,通过描述词任意切换场景,输出主体一致的视频。

该功能不局限于单一对象,而是面向“任意主体”,无论是人物、动物、商品,还是动漫角色、虚构主体,都能确保其在视频生成中的一致性和可控性,这是视频生成领域的一大创新。Vidu 也是全球首个支持该能力的视频大模型。

比如进行人物角色的“主体参照”,无论是真实人物还是虚构角色,Vidu 都能保持其在不同环境中、不同镜头下的形象连贯一致。如生数科技董事长、CEO唐家渝在现场展示了通过提供陈晓旭扮演的林黛玉形象后,生成的不同场景、不同着装下,“林黛玉喝咖啡”镜头都能看出是“同一个林黛玉”。

生数科技董事长、CEO唐家渝在现场展示“主体参照”功能。新京报贝壳财经记者 罗亦丹 摄

AI视频创作连贯性将大大提升 AI完整叙事时代来临

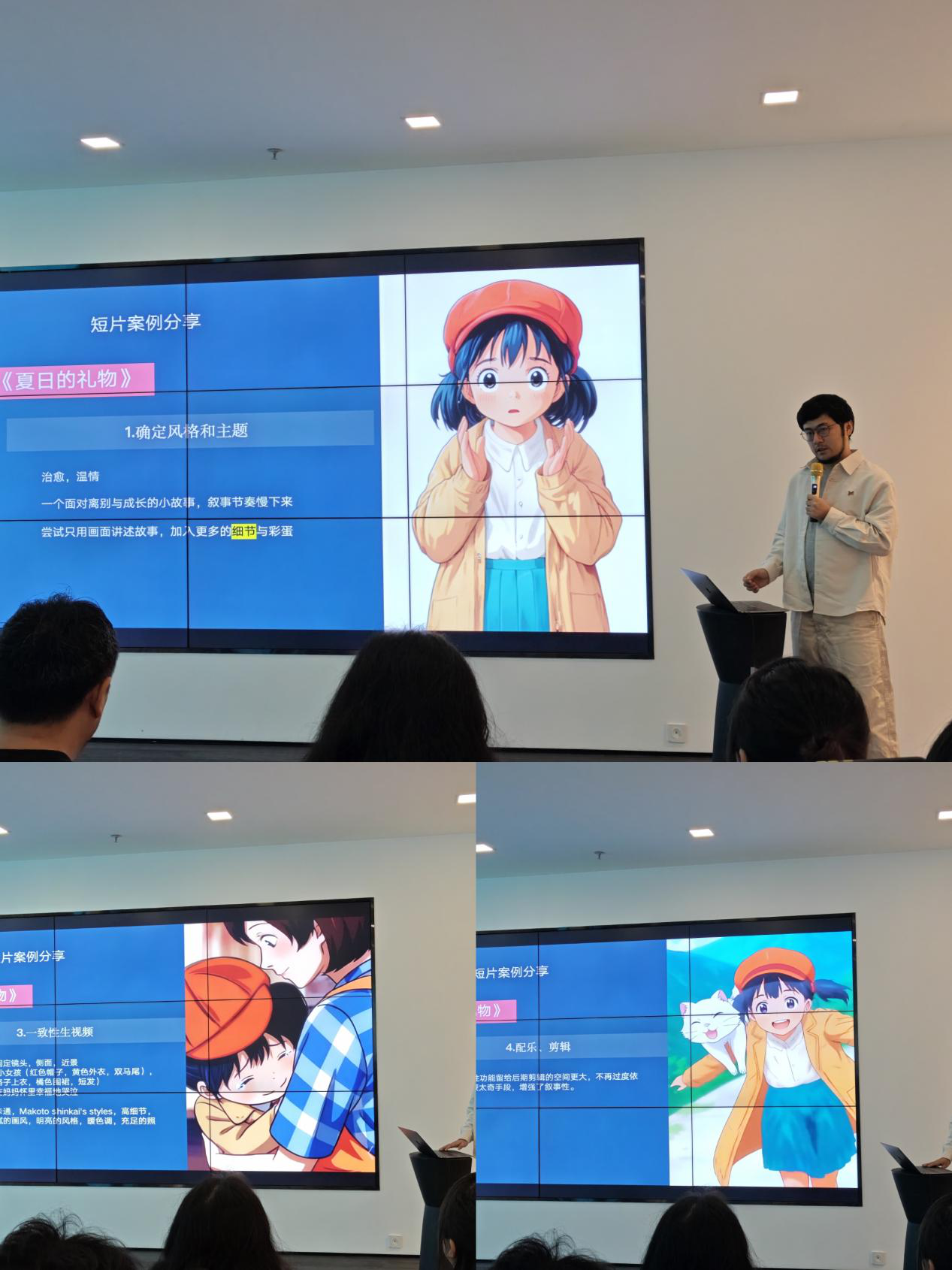

依据该功能,中央广播电视总台导演、AIGC艺术家石宇翔(森海荧光)创作了一条动画短片《夏日的礼物》,在分享创作流程中他表示,与基础的图生视频功能相比,“主体参照”功能摆脱了静态图片的束缚,生成的画面更具感染力和自由度,让创作的连贯性大大提升。同时帮助他节约7成左右的生图工作量,显著提效,让他能够将更多精力放在故事内容的打磨上,而非生成图片素材上。同时,一致性让后期剪辑也更加方便。

中央广播电视总台导演、AIGC艺术家石宇翔现场展示通过“主体参照”功能创作的动画,可以看出在该动画中主角形象保持了稳定。新京报贝壳财经记者 罗亦丹 摄

唐家渝表示, "主体参照"这一全新功能的上线,代表着 AI 完整叙事的开端,AI 视频创作也将迈向更高效、更灵活的阶段。无论是制作短视频、动画作品还是广告片,在叙事的艺术中,一个完整的叙事体系是“主体一致、场景一致、风格一致”等要素的有机结合。

因此,视频模型要达到叙事的完整性,就必须在这些核心元素上实现全面可控。“主体参照”功能是 Vidu 在一致性方面迈出的重要一步,但这仅仅是开始。未来,Vidu 将继续探索如何精确控制多主体交互、风格统一、多变场景稳定切换等复杂元素,以满足更高层次的叙事需求。

他表示,从更长远的视角来看,一旦实现了全面的可控性,视频创作行业将经历一场颠覆性的变革。届时,角色、场景、风格,甚至镜头运用、光影效果等元素,都将转化为可灵活调整的参数。用户只需要动动手指、调调参数,就可以完成一部影像作品的创作,而每一部作品的背后,也将是用户基于AI构建出的独特世界观和自我表达。

新京报贝壳财经记者 罗亦丹 编辑 王进雨 校对 杨利