开栏语

当人工智能的浪潮席卷全球,北京正以科技创新之姿,成为AI大模型领域的战略高地。从智源研究院的“悟道”大模型问世,到“天使投资人”模式孵化顶尖学者,再到月之暗面、DeepSeek、智谱等人工智能独角兽崛起,这座城市不仅汇聚了前沿技术,更以开放生态孕育突破性成果。

如今,北京正积极打造“全球开源之都”,一大批研发机构、企业积极拥抱开源,而开源也已深入到汽车、机器人等众多行业。发展AI将是一场科技长征,新京报AI研究院将深度访谈此次AI浪潮的亲历者与见证人,讲述AI竞争新格局与背后的故事。

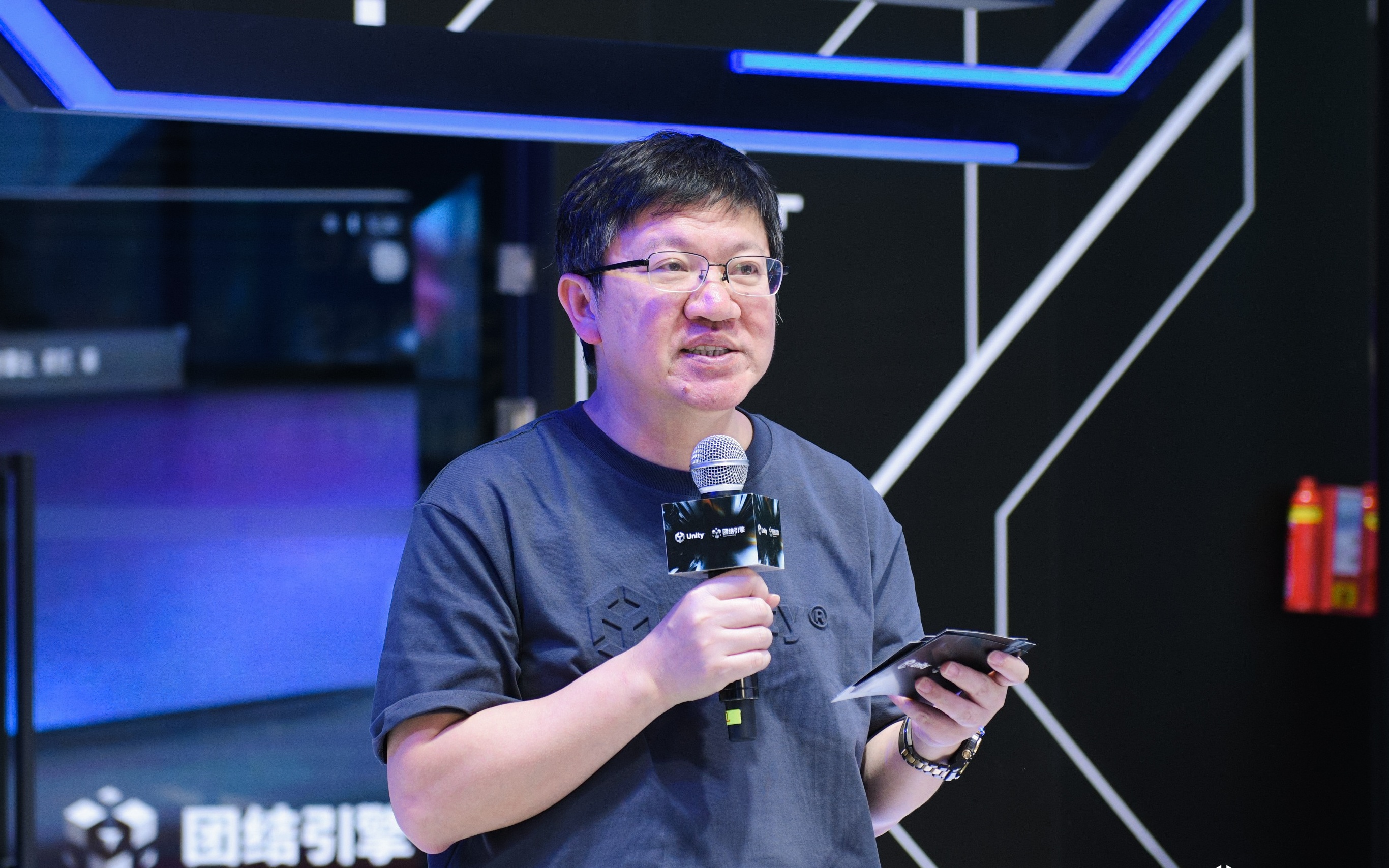

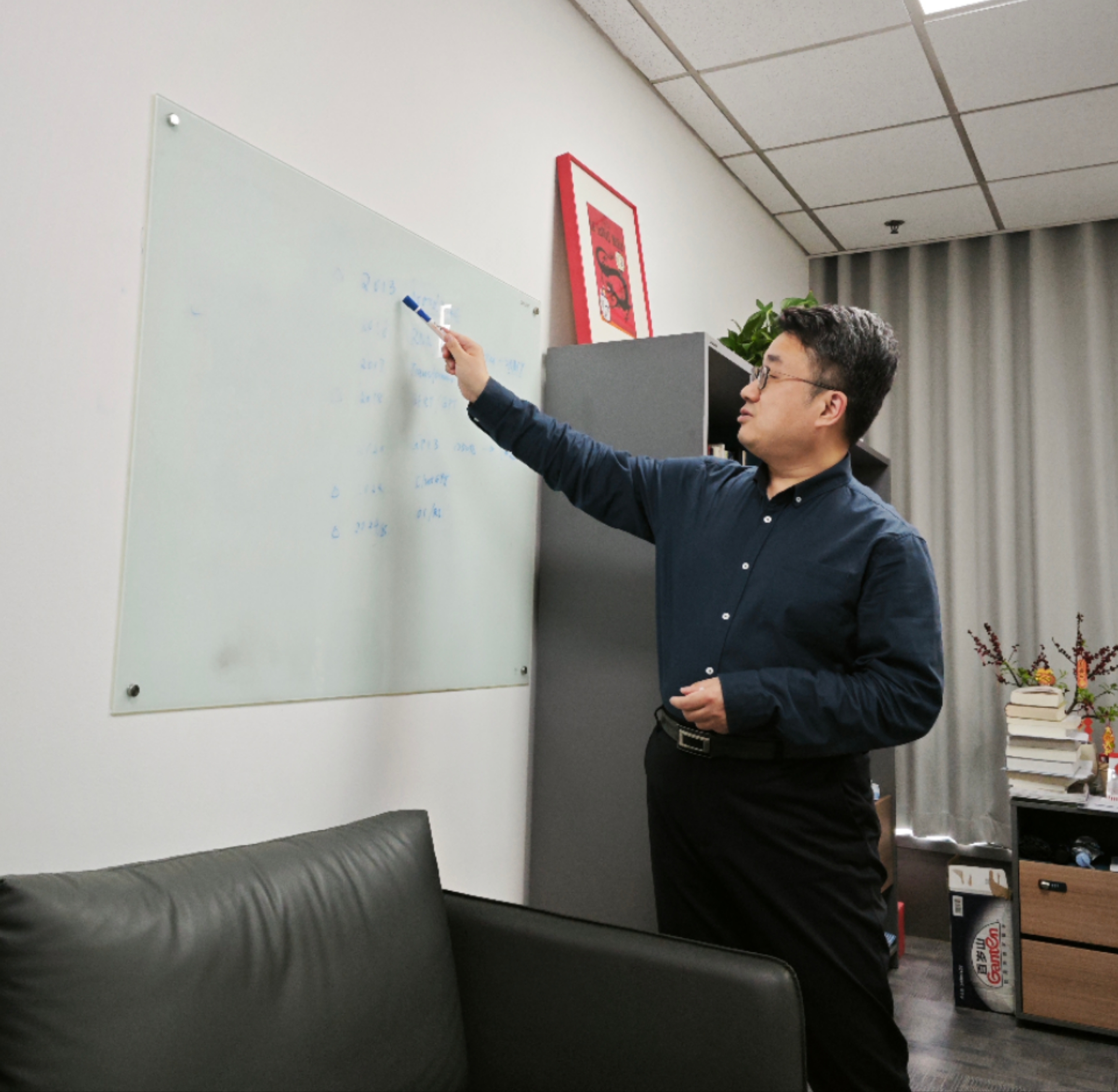

刘知远向记者讲解AI技术发展历程。 新京报贝壳财经记者 罗亦丹 摄

迈入2025年,中国AI(人工智能)站上足以与美国分庭抗礼的战略制高点。这一年,刘知远已经在AI追赶的路上走了近20年。

作为清华大学副教授、面壁智能联合创始人兼首席科学家,五年前,他训练了中文预训练模型的第一个版本,而由他参与、智源研究院发布的“悟道2.0”也成为中国第一个万亿大模型。

彼时,一个争论的焦点就是大模型研发应该“从大炼模型,到炼大模型”。2023年,ChatGPT破圈宣布了“炼大模型”路线的正确。

如今,面对DeepSeek走红,刘知远表示,“2024年时,还有很多投资人问我‘你觉得中国AI跟美国比是越来越近,还是越来越远’,我的回答始终是越来越近”。DeepSeek的出现是一个非常强有力的信号,让人看到世界舞台上,中国的人工智能技术已经具有一席之地。

刘知远亲历了符号主义黄昏下的困惑、见证了深度学习浪潮掀翻传统范式,更是中国AI大模型创业浪潮中的深度参与者之一。2023年至今,国内多个AI“小龙”“小虎”涌现,大模型百花齐放。在刘知远看来,DeepSeek成功的前提是具备了匹配资金和技术的“天才土壤”,这也是其带给业内的最大启示。

在接受新京报AI研究院专访时,刘知远笃定,AI创业者的终极目标是奔向AGI(通用人工智能),但过程绝非坦途,并提醒市场需要更多耐心:一个投资人投了“六小虎”但没有投DeepSeek,不见得就是投错了,难道中国不允许出现10个以上的DeepSeek?为什么不能等一等这些潜在的DeepSeek成长?

启蒙·越来越近的追赶

新京报AI研究院:你从什么时候开始研究AI?AI大语言模型技术何时给你“第一次震撼”?

刘知远:我2006年读研究生时开始从事自然语言处理研究,那时自然语言处理还处在统计学习的时代,深度学习的时代尚未到来。

2011年至2012年,我的老师孙茂松教授申请了科技部的973计划项目,这项基础研究课题项目的资金额达到数千万元,是国内最早在自然语言处理方向上获得大规模支持的专项之一,如果说哪一个时间点对中国AI大模型的发展具有深远影响,这件事就是其中之一。

孙老师认为,既然要做5年的项目,就要找比较前沿性、前瞻性的方向。为了确定这笔资金的具体使用方法,他组织了北大、哈工大、中科大自动化所、百度在内的几个单位以及全国自然语言处理领域半数顶尖学者进行讨论,最终定下了一个方向:深度学习。

这一项目申请成功之后,2013年,国外发布了word2vec方法。简单来讲,word2vec首先发现了词可以用向量表示,这是深度学习在自然语言处理领域应用上里程碑式的成功,也是深度学习对我的“第一次震撼”。于是我们立即开始跟进。当时,我们与国外领先水平大概有三四年的差距。

实际上,国内学界开始大规模认可深度学习,达成共识是2015年,比2013已经晚了两三年,但大体上,我们一直处于不断追赶,身位越来越近的追赶过程。

新京报AI研究院:公众知晓大语言模型主要是在ChatGPT出现之后,对于学界来说,有哪些“ChatGPT时刻”?为了追赶新技术,你们做了什么?

刘知远:ChatGPT的出现确实没有给我们带来多大“震撼”,因为我们始终在关注这一领域。

在此之前,还有两个技术突破的关键节点。

2018年,谷歌发布了BERT模型,它完成了模型从专用到通用的跃迁。此前,我们需要针对每一个任务去设计模型、准备数据,模型也只能做这一个任务。BERT出现后,模型可以学习文本上的所有知识,之后进行微调即可完成更多任务。

国内很多团队也发现了这件事的重要性。2018年起,我们决定将重点转向预训练模型的研究,鼓励团队成员摒弃狭隘的专有任务导向,专注于基础模型的开发。2018年底,团队推出了首个知识增强的预训练模型,命名为“ERNIE”,并于2019年初将研究成果提交至ACL(国际计算语言学学会)。有趣的是,几乎同时,百度也发布了名为“ERNIE”的预训练模型。(注:ERNIE与BERT均是美国动画片“芝麻街”中的角色)。

这一巧合甚至引起了ACL评审主席的关注,他特意发来邮件询问我们是否存在关联,以及团队是否知晓百度的工作。我们明确表示,与百度没有任何合作,也完全不知对方的研究。最终,这篇论文被录用,成为团队在预训练模型领域引用最高的研究之一。

2020年,GPT-3发布,完成了从小模型到大模型的跃迁,OpenAI使用了1万张卡(注:GPU),这让我们看到了差距,之后就催生了“悟道”大模型。

当ChatGPT出现时,我们认为国内和国外的差距差不多是一年;直到2024年9月OpenAI发布o1模型,我们认为差距缩小到半年,因为o1推出深度思考功能半年后,DeepSeek就成功进行了复现。

攻坚·既没名也没钱,遇上“天使投资人”

新京报AI研究院:OpenAI训练GPT-3使用了上万张卡,那时国内有这样规模的算力资源吗?怎么解决算力的“缺口”?

刘知远:GPT-3出现后,我们觉得如果不马上跟进,差距就会越来越大。但当时国内即便是一线团队,训练资源也相对有限。GPT-3发布时,团队研究条件仅能使用单台机器,最多两三张GPU卡进行训练。

那时,我正在北京智源研究院担任青年科学家,这是北京市设立的新型研发机构,有一定资源优势,我向时任院长黄铁军提交了一份报告,详细介绍了大模型领域的发展趋势,希望能够在智源的支持下,尝试训练一个参数规模更大的模型。值得庆幸的是,智源的支持机制非常灵活,几天后就批准了申请并拨款支持,最终购置了10台配备A100 GPU的机器,总投入达数百万元。利用这些资源,2020年12月,我们团队训练了CPM(中文预训练模型)的第一个版本,也让我有机会参与到了大模型的浪潮之中。

新京报AI研究院:智源研究院被媒体视作中国AI的“黄埔军校”,你怎么看待其对国内AI发展起到的作用?

刘知远:智源研究院是2018年时任北京市市长倡导成立的新型研发机构,其最开始设立时的理事长由来自产业界的张宏江担任,模式非常新颖,这是理念上的前瞻性,其核心是用新型方式推动人工智能加快发展。

研究院成立之后推动了智源学者项目,这跟历史上国内的任何一种项目都不同,主张激发卓越领军人物自由探索,以提升科研原始创新的概率。因此,通过“小同行评议”,层层严苛选拔,评选出中国人工智能每个重要研究方向的代表性优秀学者。与传统科研机构不同,类似投资领域中“投资就是投人”的理念,智源也成为一批顶尖人工智能学者的“天使投资人”,以更加高效灵活的方式支持面向未来的科研探索。

它相当于在青年科学家“既没名也没钱”时支持了三年,相比其他科研项目中所常见的写本子、答辩和考核等复杂操作,这种基于对人本身的信任、国内最早以人为单位进行支持的项目,理念非常先进。

2021年,刘知远在智源“悟道1.0”发布现场。 新京报贝壳财经记者 罗亦丹 摄

弄潮·避开大厂“射程”,从局部优势领域出发

新京报AI研究院:2022年,你创立了面壁智能,这一年年底,ChatGPT也正式问世。大模型技术相继“破圈”,感受到什么变化?

刘知远:感觉2023年之后突然变忙了,节奏明显加快。但这是正常的,因为当一个领域技术成熟,特别是一些爆款出现后,一定会促使该领域的发展进入“快车道”,这是一个逐渐加速的过程,甚至我可以预见今年会更快。

对我个人来说,其实过去这十几年的感受倒没有太大区别,因为我们的愿景是要始终站在AI科技的最前沿去开展工作,只是之前在学校就能站在最前沿,而2018年之后,我们认为AI已经具备一定成熟度,可以对社会产生广泛的应用价值,研发工作也开始要求有更强的系统工程属性。这种情况下,一定要通过科技创业和产研结合的形式,才能够站在技术前沿更快地往前走。

任何对人类社会产生深远影响的技术发展都是这样。例如,信息检索技术从20世纪60年代就有人探索,而到将近2000年的时候,这项技术逐渐成熟具备商业价值,对全社会的人类有用,就产生了雅虎、Google这样的公司。如果不能顺应时势以创业公司或产研结合的形式站在合适的位置,就不能真正地推动技术发展,我们要做的就是始终站在科技创新的最前沿,前沿要求我们站在哪儿,我们就得站在哪儿。

新京报AI研究院:相比DeepSeek等参数庞大的大模型,面壁智能主打“小而美”的端侧模型,为什么确定了这个略显差异化的发展方向,而且有什么目标?

刘知远:我的目标就是让更多的智能终端装上我们的模型,而AI创业者的终极目标肯定是奔向AGI(通用人工智能)。

对于面壁,我们先定的英文名“model best”,即我们要做最好的模型。而中文名必须以M和B作为首字母,找来找去,我们认为面壁比较符合人工智能的目标,既有科幻气质,又隐喻人类智能发展到最高水平应该可以自省。

确立了最终目标后,需要看清形势,准确预判,打好自己的每一场仗。《论持久战》的思想精髓就非常值得创业者去借鉴,因为奔向AGI本身也是一个“持久战”,在这一过程中敌人是不确定的,要跟自己PK,跟友商们PK,跟充满不确定的未来PK,而跑到终点的才是胜利者。

我们现在还很弱小,如何一点点壮大,在AGI漫漫长征中不掉队、取得最终胜利?市场本身非常大,有的公司铺得很开,这种情况下作为创业公司,在资源有限、不可能拥有全面压倒性优势的情况下,一定要战略性找到具有相对优势的局部战场,通过运动战,在合适时间、合适战场,集中局部优势兵力,打出一场漂亮的战役。唯有坚定地取得一场关键性战役的胜利,方可占领根据地。

面壁怀抱着一个长期的愿景,但要有战略、分阶段地去实现,尤其是避开当前大厂的“射程”,从局部优势领域出发,一步一步来。

新京报AI研究院:怎么看待人工智能高速发展中的风险挑战和相应的监管体系?端侧模型本地化的特性所带来的数据保护优势,是否为面壁发展端侧模型的契机之一?

刘知远:人工智能的高速发展与安全监管是相辅相成的关系,需要又快又稳的平衡。人工智能从业者既要加倍努力,全面推进人工智能科技创新、产业发展和赋能应用,也要同时在高速发展中“系好安全带”,推动人工智能向有益、安全、公平方向健康有序发展。

端侧大模型在离用户最近的地方,所有数据算力都在本地,得以极大保护用户隐私,断网弱网服务依然保持稳定,可以更加灵敏、高效、体贴地响应人们高频的日常需求。尤其在汽车座舱等典型场景中,实时产生的大量声音、图片、视频流数据在车端本地处理,需要保证车内数据不外传,用户会更倾向个人隐私和数据安全高的方案。

出圈·AGI之路非坦途,资本与市场的不信任要挺住

新京报AI研究院:2024年,除了“AI六小虎”之外,面壁智能曾和DeepSeek一起跻身“6+2”,你怎么看待今年春天DeepSeek-R1的火爆?

刘知远:DeepSeek的启示是,面对算力限制,通过算法创新与高效训练,也有办法做出比较好的模型,这是它的价值。

2024年时,还有很多投资人问我“你觉得中国AI跟美国比是越来越近,还是越来越远”,我的回答始终是越来越近,但很多人还是有顾虑,认为中国算力一旦被“卡脖子”,会远远赶不上。DeepSeek的出现是一个非常强有力的信号,让人看到世界舞台上,中国的人工智能技术已经具有一席之地。

未来,AI的发展有两大主旋律,一个是能效更高,其实就是Densing(增加密度)的过程,用更低成本训练更好的大模型;另一个就是能力更强,具备越来越强的智能水平。未来这两大方向相互作用,一起往前走。

过去一年,我们一直在极致地追求更高能力密度的模型。我们要做的是根据Densing Law (密度定律)不断改进模型制造工艺、不断提高模型的能力密度,追求一个更加陡峭的模型成长曲线,我们要通过这种方式来实现模型的高质量发展,从而获得模型在市场上的竞争力。

新京报AI研究院:当DeepSeek走红后,许多AI公司改变了发展方向,也有声音质疑投资者“为什么没有投中DeepSeek”,对此你怎么看?

刘知远:DeepSeek的出现是一次考验。如果你认为大模型不是泡沫,那出现低谷时为什么要退场?低谷其实就是在让真正对大模型有坚定信心的人留下来。

AGI之路的实现不是轻而易举的,它是一次科技革命,这意味着我们不仅经历技术上的挑战,还可能存在各种现实上的张力,一个团队可能一年之内突然有非常多的进展,也可能两年都没有太大进展,此时资本与市场的不信任能否挺住,是否有战略定力,对团队是一种考验。

2000年时,互联网极其火爆,但后来出现了互联网泡沫,导致将近10年时间计算机系招生的分数比许多其他院系差,大家觉得这个行业“没前途”了,但中国现在的许多互联网巨头,都是挺过了互联网泡沫的冬天才成长起来的。中国AI大模型行业能够做好,靠的是真正相信AGI的人,相信自己所做事情的价值,不轻易放弃。在历史的长河里,做对的事往往比较难。

新京报AI研究院:DeepSeek创始人梁文锋此前从事量化投资,有声音认为相比其他初创公司,DeepSeek本身“不差钱”,这是它成功的关键因素吗?

刘知远:这其实反映了我国当前需要解决的一些问题:第一,他有理想主义,有长期AGI技术的理想。第二,他也不差钱,可以不受干扰更有定力地做事。二者兼顾让他可以把事情做得很好,而现在世界上绝大多数的人是只有钱或者只有技术,这就是风险投资存在的必要性。

我觉得DeepSeek对我们最大的启示是,上面二者的结合会产生很大的“化学反应”。如果初创公司拿到资金后面临着每天的现实追问,这种状态下显然就“静不下来”。

如何把资源与技术真正做到更优化地匹配,也是我们当前面临的问题,相较而言可能美国科技创新生态更加耐心主义。一个投资人投了“六小虎”但没有投DeepSeek,不见得就是投错了,难道中国不允许出现10个以上的DeepSeek吗?为什么不能等一等这些潜在的DeepSeek成长呢?

鲁迅先生曾说过,“在要求天才的产生之前,应该先要求可以使天才生长的民众。”这是没错的,天才刚生下来时也是一个孩子,不可能第一声啼哭就是优美的诗歌。

记者联系邮箱:luoyidan@xjbnews.com

新京报贝壳财经记者 罗亦丹

编辑 王进雨

校对 贾宁